Kommunikation ist im gesamten Tierreich verbreitet. Unterschiedliche Arten nutzen Körpersprache – etwa den Schwänzeltanz der Bienen – oder Stimmorgane, wie den Gesang der Wale, um Informationen über Futterquellen oder sogar ihre Emotionen zu übermitteln. Nach heutigem Wissensstand bleibt jedoch die menschliche Sprache eines der zentralen Merkmale, das uns von Tieren unterscheidet: Sprache ist ein wesentlicher Bestandteil dessen, was uns zu Menschen macht. Über Jahrtausende hinweg haben sich zahlreiche Sprachen entwickelt, mit deren Hilfe wir täglich mit unseren Mitmenschen kommunizieren. Jedes Kind, das in einem menschlichen Umfeld aufwächst, beginnt früher oder später zu sprechen und erwirbt dabei die Sprache seiner Umgebung.

Erkrankungen, die Sprache verhindern

Es gibt Störungen der Sprachproduktion, bei denen Betroffene durchaus in der Lage sind, Gesagtes zu verstehen, zu verarbeiten und auch Sprache zu produzieren. Die dafür notwendige Muskulatur lässt sich jedoch nicht mehr willentlich steuern. Eine Erkrankung, die dies verursacht, ist beispielsweise die Amyotrophe Lateralsklerose (kurz ALS), an der auch Stephen Hawking litt. Bei vollem Bewusstsein werden dabei zentrale Nervenzellen zerstört, was nach und nach zu einer fortschreitenden Lähmung sämtlicher Muskeln im Körper führt. So verlor auch Stephen Hawking im Laufe der Zeit die Fähigkeit zu sprechen. Mit der ihm noch verbleibenden Fähigkeit, zunächst seinen Daumen und später seine Wange zu bewegen, steuerte er einen Computer, der das Sprechen für ihn übernahm. So hielt er bis zum Ende seines Lebens Vorträge – mit der uns allen bekannten, blechernen Computerstimme (Ashish, 2016).

Eine weitere Erkrankung mit solchen Ausfallerscheinungen ist das sogenannte Locked-in-Syndrom. Es handelt sich dabei um einen Zustand, in dem Betroffene zwar alles wahrnehmen, jedoch nicht mit ihrer Umwelt kommunizieren können. Seit 1986 ist das Syndrom definiert als Tetraplegie (Lähmung aller vier Extremitäten) mit Anarthrie (Sprachverlust) bei gleichzeitig erhaltenem Bewusstsein. Die Unfähigkeit zu sprechen wird durch eine beidseitige Lähmung von Gesicht, Zunge, Luftröhre und Kehlkopf (Stimmbänder) verursacht. Häufig bleibt lediglich die seitliche Augenbewegung erhalten – und stellt damit die einzige verbliebene Kommunikationsmöglichkeit dar (Smith & Delargy, 2005).

Eine mögliche Ursache dafür sind Schlaganfälle, die eine Schädigung tiefer liegender Hirnstrukturen, die zur Verschaltung sämtlicher Signale benötigt werden, verursachen. Selten können auch Intoxikationen oder eine vollständige Lähmung der Nerven und Muskeln durch ein so genanntes Guillain-Barré-Syndrom entstehen (Maiese, 2024).

Dank technologischer Fortschritte – wie dem Hawking‘schen Computer – stehen Betroffenen heute Hilfsmittel zur Verfügung. Ist noch eine minimale Restfunktion kleiner Muskeln vorhanden, kann diese etwa zum Tippen eingesetzt werden. Der Computer wandelt den geschriebenen Text schließlich in Sprache um. Allerdings ist die Sprachproduktion mithilfe dieser Technik sehr langsam. Während beim natürlichen Sprechen bis zu 120 Wörter pro Minute möglich sind, lassen sich auf diese Weise lediglich 5 bis 10 Wörter pro Minute erzeugen. Eine flüssige, natürliche Kommunikation ist dadurch stark eingeschränkt.

Elektrodenplatte soll Signale erkennen

Edward Chang, ein Neurochirurg aus San Francisco, und sein Team haben es sich zur Aufgabe gemacht, Patient:innen mit den vorher genannten Erkrankungen die Stimme zurückzugeben. In den vergangenen Jahren arbeiteten sie Schritt für Schritt daran, die Sprachproduktion im menschlichen Gehirn zu entschlüsseln. So konnten sie herausfinden, welche Hirnareale für die Formung einzelner Silben und Wörter verantwortlich sind. Diese Hirnareale steuern gemeinsam die Muskulatur von Zunge, Kehlkopf und Rachen – und ermöglichen so die Bildung einzelner Silben.

Nach intensiver Forschung gelang es ihnen, jeder einzelnen englischsprachigen Silbe eine spezifische Region im Gehirn zuzuordnen (Bouchard et al., 2013). Nachdem das Forschungsteam die Funktion der einzelnen Areale verstanden hatte, zeichneten sie die Hirnaktivität eines erkrankten Menschen auf und ließen diese mithilfe eines Computerprogramms in Sprache umwandeln.

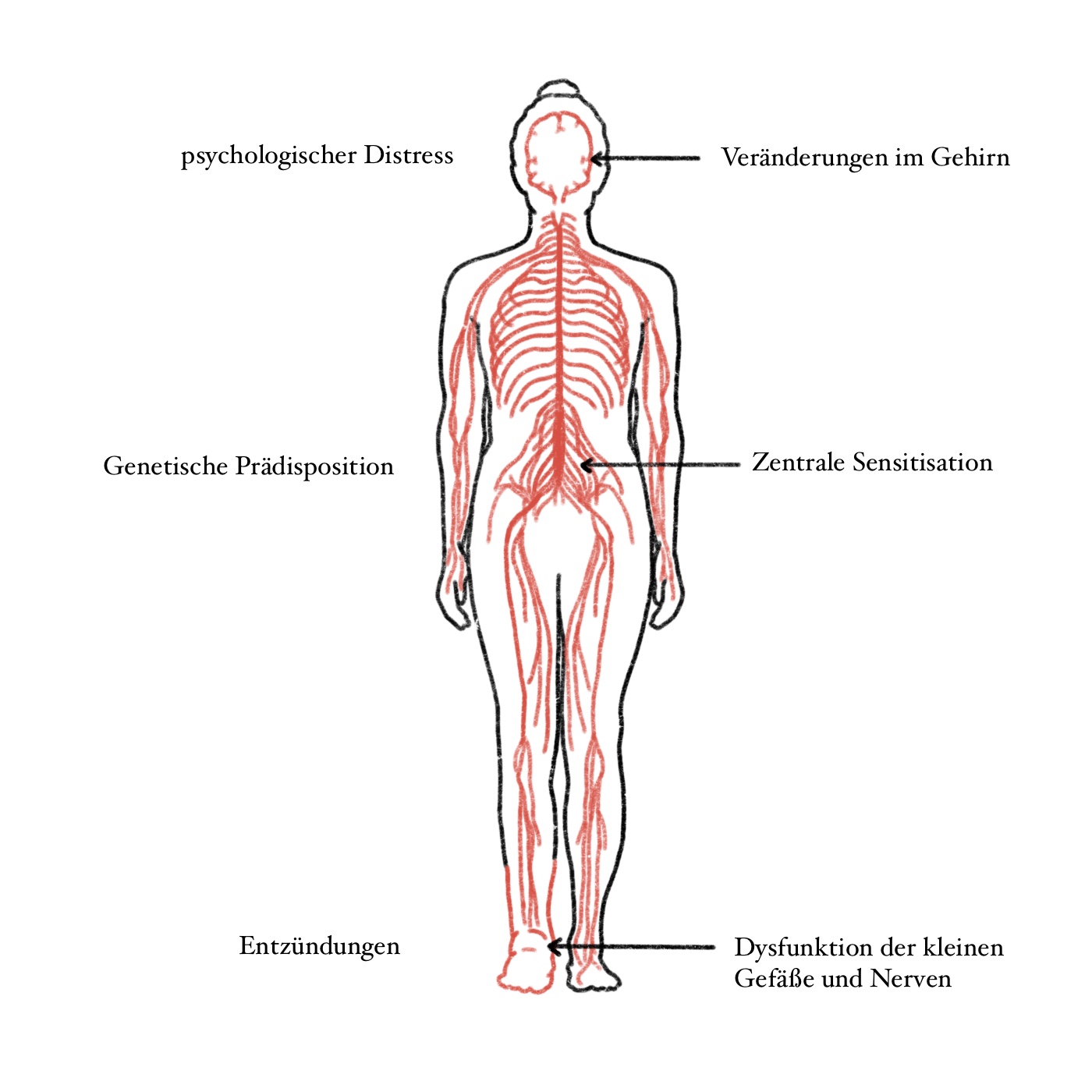

Diese Hirnareale spielen eine Bedeutung bei dem Formen von Worten.

Es könnte also künftig möglich sein, Menschen, die zwar Sprache im Gehirn produzieren, aber keine Kontrolle über ihre Muskulatur haben, eine Stimme zu verleihen. Bisher wurde dieses Verfahren jedoch erst bei einer einzigen Person erfolgreich angewendet. Im Folgenden lernen wir seine Geschichte kennen.

Lernt Poncho kennen

Poncho ist 2022 gerade 37 Jahre alt. Vor 15 Jahren hatte er einen schweren Autounfall, in dessen Folge es auch zu einem Schlaganfall in seinen tieferen Hirnregionen kam. Heute kann er seine Augen und seinen Nacken teilweise bewegen, doch trotz vollen Bewusstseins ist ihm – abgesehen von einzelnen Lauten – keine Sprachproduktion mehr möglich.

Früher war an seiner Kappe ein Stab befestigt, mit dem er auf einem Computerbildschirm tippen und etwa fünf Wörter pro Minute erzeugen konnte. Diese Wörter wurden anschließend von einem Computer vorgelesen – was seine Kommunikationsfähigkeit stark einschränkte.

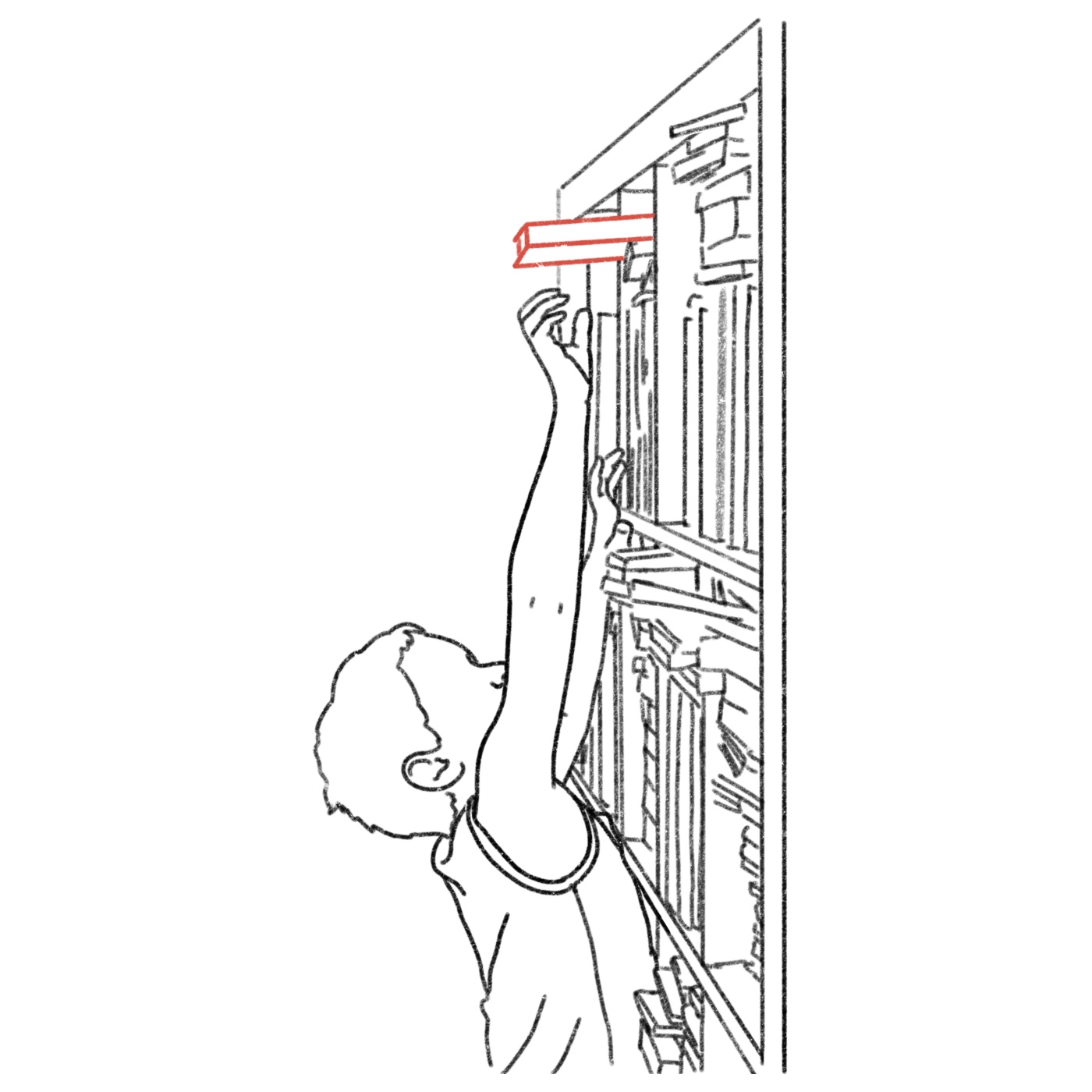

Daher erklärte sich Poncho bereit, an dem Projekt von Edward Chang teilzunehmen. Ihm wurde eine 6,7 x 3,5 cm große Elektrodenplatte direkt unter dem Schädelknochen auf das Gehirn implantiert. Zusätzlich wurde am Scheitelpunkt des Schädels ein Konnektor unter die Haut eingesetzt. Dieser zeichnete die Signale der Elektrodenplatte auf und ermöglichte die Verbindung zum Computer (Silva et al., 2024).

So wurde die Elektrodenplatte im Hirn von Poncho implantiert.

Die implantierte Elektrodenplatte erfasste sämtliche neuronalen Signale, die mit der Produktion einzelner Wörter verbunden sind. Zu Beginn sollte der Computer einen Wortschatz von 50 Wörtern erlernen. Poncho trainierte über eineinhalb Jahre hinweg regelmäßig, diese 50 Wörter „nachzusprechen“. So konnten die Elektroden die jeweils aktivierten Bereiche seines Sprachzentrums im Gehirn aufzeichnen. Nachdem der Computer gelernt hatte, welche Hirnregionen bei der Produktion der Silben benötigt werden, konnte er diese Muster erkennen und wiedergeben.

Um eine schnellere und natürlichere Sprachproduktion zu ermöglichen, kamen künstliche Intelligenz und Computerprogramme zum Einsatz, die Sprachmuster sowie die Häufigkeit verwendeter Vokabeln erlernten. Im weiteren Verlauf wurden Modelle entwickelt, die die Spracherkennung verbessern und vorhersagen sollten, welches Wort mit hoher Wahrscheinlichkeit als Nächstes folgt. Dadurch konnte die Sprachwiedergabe beschleunigt und gleichzeitig die Fehlerrate bei der Erkennung der Wörter unter 30 % gedrückt werden. Ist Poncho über seinen Konnektor mit einem Computer verbunden, kann er mithilfe dieses Systems zumindest kurze Wörter aussprechen. Anfangs war es dem Forschungsteam noch unklar, ob es einem Betroffenen nach so vielen Jahren ohne Sprachproduktion überhaupt noch möglich sein würde, vollständige Wörter oder Sätze zu äußern. Doch genau das gelang nahezu problemlos.

Im folgenden Video könnt ihr euch selbst ein Bild von der Funktionsweise des Computers machen:

Mit diesem Projekt ist dem Forschungsteam rund um Edward Chang Beeindruckendes gelungen. Dennoch ist Poncho derzeit die einzige Person weltweit, bei der eine solche Elektrodenplatte implantiert wurde.

Noch ein weiter Weg

Der Wortschatz von Ponchos System umfasst bislang etwa 50 Wörter – zum Vergleich: Die englische Sprache kennt über 600.000 Wörter. Ein nächstes Ziel ist die Fähigkeit, ein flüssiges Gespräch zu führen – dafür werden etwa 800 Wörter benötigt. In Zukunft sollen sowohl die Sprachmodelle weiter angepasst als auch der Wortschatz erweitert werden. Derzeit steht diese Technologie jedoch ausschließlich für die englische Sprache zur Verfügung. Die Entwicklung für andere Sprachen wäre ein nächster wichtiger Schritt.

Die Finanzierung solcher Projekte gestaltet sich jedoch schwierig – insbesondere bei selten auftretenden Krankheitsbildern. Daher dürfte es noch einige Jahre dauern, bis entsprechende Systeme breiter verfügbar sind. Ob das maschinelle Lernen künftig auch bei weiteren Betroffenen erfolgreich einsetzbar ist, muss die Forschung erst noch zeigen.

Dennoch bietet dieses Projekt erstmals eine Möglichkeit, die Kommunikation von Menschen mit Locked-in-Syndrom oder ähnlichen Einschränkungen deutlich zu verbessern. Das langfristige Ziel der Forschungsgruppe ist es, soziale Interaktion durch Sprache zu ermöglichen – und so barrierefreies Sprechen zu garantieren für alle Patient:innen, denen die Sprache genommen wurde (Moses et al., 2021).

Bouchard, K. E., Mesgarani, N, Johnson, K. and Chang E.F. (2013). Functional

Organization of Human Sensorimotor Cortex for Speech Articulation. Nature. 2013

March 21; 495(7441): 327–332. doi:10.1038/nature11911

Liu, Y.; Zhao, Z.; Xu, M. et al. (2023). Decoding and synthesizing tonal language speech

from brain activity. Science Advances. 9, eadh0478 (2023)

Moses, D.A.; Metzger, S.L.; Liu, J.R. et al. (2021). Neuroprothesis for Decoding Speech in

a Paralyzed Person with Anarthria. New England Journal of Medicine. 2021 July 15;

385(3): 217–227. doi:10.1056/NEJMoa2027540.

Silva, A.B; Littlejohn, K.T.; Liu, J.R.; Moses, D.A. et Chang, E.F. (2024). The speech

neuroprothesis. Nature Reviews Neuroscience. 2024 July ; 25(7): 473–492.

doi:10.1038/s41583-024-00819-9

Falling Walls Foundation (2022). Edward Cheng: Breaking the Wall of Speech Loss. Falling

Walls Science Summit 2022. https://www.youtube.com/watch?v=B1QBOjX5gAM

WIRED Events. (2022). Decoding speech: Dr Edward Chang | WIRED Health;

https://www.youtube.com/watch?v=k5PvYdpLwrc

Ashish (2016). How Did Stephen Hawking’s Communication System Work?. Science Abc.

https://www.scienceabc.com/innovation/stephen-hawking-cheek-communication-help-

computer-speech-generating-device.html)

Smith, E. & Delargy, M. (2005). Locked-in syndrome. BMJ. 2005 Feb 19;330(7488):406–

409. doi: 10.1136/bmj.330.7488.406

Maiese Kenneth (2024). Locked-in-Syndrom. MSD Manuals. Merck & Co., Inc., Rahway,

NJ, USA

.jpg)