Warum das wichtig ist: Die Fortschritte in der Forschung zu Künstlicher Intelligenz und in der Robotik eröffnen ungeahnte Möglichkeiten. Ob eine Maschine intelligent ist, lässt sich durch den Turing-Test und seine Erweiterungen überprüfen. Nur, welche Form von Intelligenz wünschen wir uns in unseren Maschinen? Eine stets rational agierende „machina oeconomica“, eine menschenähnliche „machina humana“, oder gibt es eine dritte Option? Ein Lösungsansatz ist der ethische Imperativ, der in einer Mensch-Maschinen-Kollaboration normiert, dass die Anzahl der entstehenden Wahlmöglichkeiten stets zunehmen soll.

Wir sehen nicht, dass wir nicht sehen

Seit es Menschen gibt, existiert der Wunsch, die Zukunft zu kennen. Unsere Vorfahren versuchten schon bei der Jagd auf das erste Mammut das Verhalten des Jagdobjektes vorauszusehen und ein dafür passendes und erfolgversprechendes Jagdszenario zu entwickeln. Ebenso alt ist die Beziehung des Menschen zu seinen Maschinen. Für die Jagd und das tägliche Überleben wurden Werkzeuge entwickelt, und durch die stetige technologische Weiterentwicklung dieser Werkzeuge erschufen Menschen schließlich Maschinen, die sie bestmöglich unterstützen sollten. Die ersten Ideen zu selbständig handelnden intelligenten Maschinen und Automaten wie Robotern findet man u.a. in der Mythologie der griechischen Antike (Mayor, 2018). Dabei versuchten innovative Menschen, ihre biologischen Fähigkeiten auf Maschinen zu übertragen und diese zu imitieren. Tatsächlich ist der Mensch in besonderem Maße befähigt, in alternativen Zukünften zu denken und schnell situationsabhängige Entscheidungen zu treffen. Ein bekanntes Experiment, welches dies treffend illustriert, ist jenes mit dem „blinden Fleck“ (Foerster, 1993).

Unser Gehirn vervollständigt Wahrnehmungen und kann Objekte in wenigen Millisekunden erkennen. Genau dieselben Fähigkeiten wünschen sich Menschen seit Jahrtausenden für ihre Maschinen. Sie sollen sie darin unterstützen, sich schnell einen vollständigen Überblick zu verschaffen, und entscheidungsrelevante Daten bereitstellen. Unter den vielen modernen Anwendungsgebieten möchte ich das Forschungsfeld herausgreifen, das mir besonders nahesteht: die Wirtschaftswissenschaften, in denen es darum geht, Kunden- und Marktverhalten, Aktienpreise oder (latente) Chancen und Risiken zu antizipieren. Menschen wünschen sich also intelligente Maschinen.

Der Turing-Test

Wann ist eine Maschine als intelligent zu bezeichnen? Es gibt unzählige Definitionen für Intelligenz, sowohl für Menschen als auch für Maschinen. Die Machine Learning-Forscher Legg und Hutter haben eine universelle Definition gefunden, die sich auf mögliche künstliche Intelligenz gut anwenden lässt: „Intelligence measures an agent’s ability to achieve goals in a wide range of environments.“ (Legg & Hutter, 2017, 415) Demnach hat der Agent (die Maschine) die Fähigkeit, in einer (unendlichen) Vielzahl von Möglichkeiten mit entsprechenden Wahrscheinlichkeiten ein gewisses Ergebnis zu erzielen, welches dann mit jenem anderer Agenten (Maschinen) verglichen werden kann. Die Grenzen dieser Definition liegen im sogenannten „Ockhams Rasiermesser“ (das bedeutet, es ist immer der einfachere Weg vorzuziehen, auch wenn er vielleicht nicht zum Erfolg führt), und in der faktischen Nichtberechenbarkeit der „Kolmogorow-Komplexität“ (diese beschreibt die Komplexität der Umgebungen).. Dennoch eignet sie sich als Arbeitshypothese, um sich der Frage der Maschinenintelligenz anzunähern.

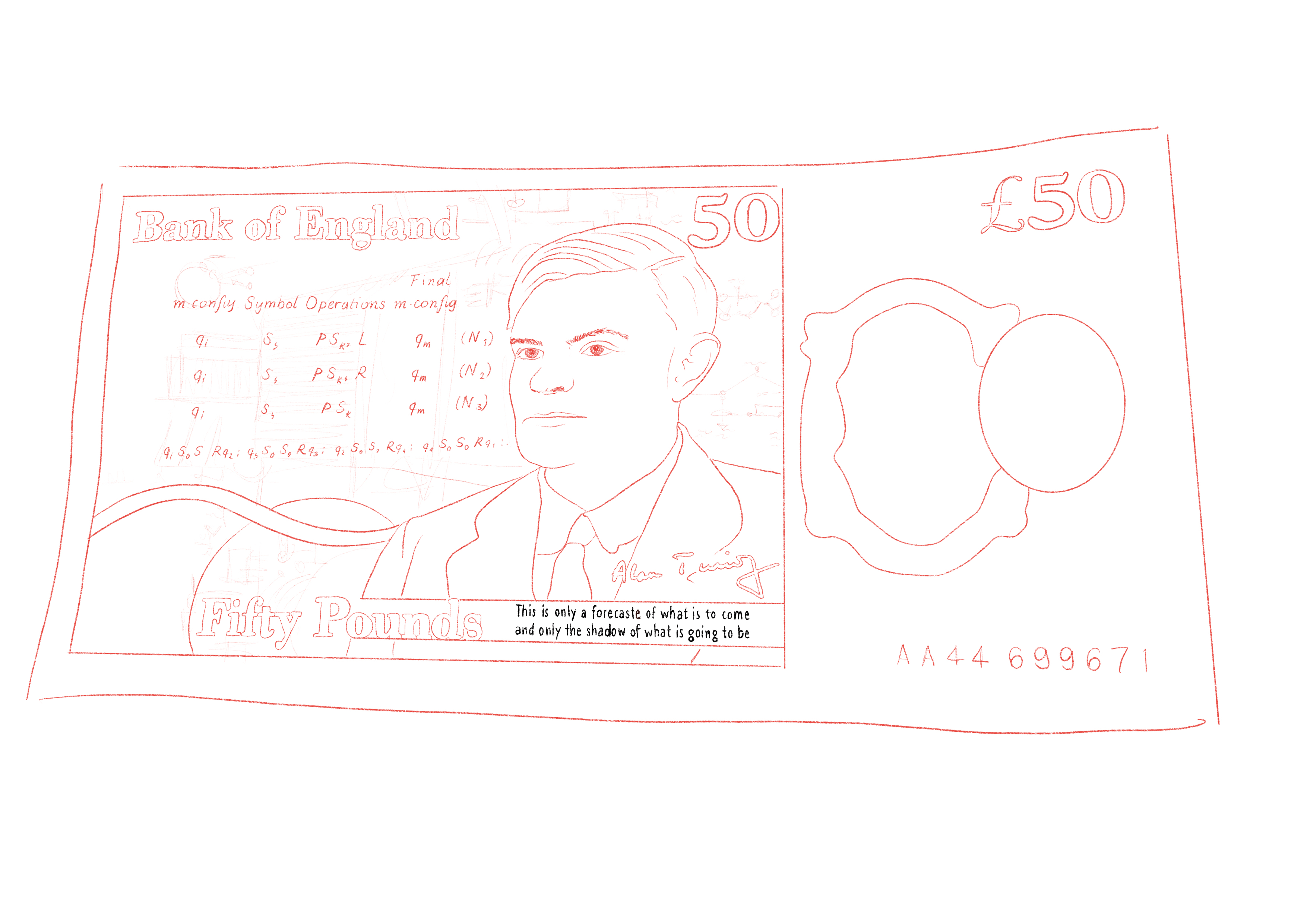

Ob ein Mensch oder eine Maschine Fragen besser beantworten kann bzw. ob man überhaupt erkennen kann, ob die Antwort auf eine Frage von einem Menschen oder einer Maschine stammt, dazu war die Arbeit des britischen Mathematikers Alan Turing bahnbrechend (Turing, 1950). Im nach ihm benannten Turing-Test führt ein:e menschliche:r Beobachter:in ein intensives Gespräch mit zwei nicht identifizierbaren und nicht direkt beobachtbaren Partnerinnen. Die Kommunikation erfolgt digital. Eine der Partnerinnen ist ein Mensch, die andere eine Maschine (z.B. ein Computer). Kann die Beobachterin oder der Beobachter nach Abschluss des Gesprächs nicht feststellen, welcher der beiden Partnerinnen der Mensch und welcher die Maschine ist, verfügt die betreffende Maschine über eine dem Menschen ebenbürtige Intelligenz. Der Turing-Test gilt bis heute als Gold-Standard für die Maschinenintelligenz.

Abbildung 1: Alan Turings Zitat hat bis heute nichts von seiner Aktualität eingebüßt. Über den technischen Fortschritt sagte er: "This is only a foretaste of what is to come and only the shadow of what is going to be"

Ein neuer Ansatz für den Turing-Test

Der Mathematiker und Philosoph Judea Pearl hat in der wissenschaftlichen Diskussion zum Turing-Test eine weitere Hypothese aufgestellt: Intelligente Maschinen(systeme) und künstliche Intelligenz sind erst dann als solche zu bezeichnen, wenn sie nicht nur prinzipielle entscheidbare, sondern auch „what-if?“-Fragen stellen und beantworten können (Pearl, 2019). Maschinen sind bereits sehr gut darin, Sensitivitätsanalysen anzustellen, also die Auswirkung der Veränderung einzelner oder mehrerer Parameter auf den Gesamtzustand einer Entscheidungsgrundlage zu ermitteln, aber die Kreativität des „was-wäre-wenn“ wäre ein ganz entscheidender Fortschritt. Ein Ansatz, dies zu erfassen, ist der Lovelace-Test, benannt nach der britischen Mathematikerin Ada Lovelace. In diesem Test wird von einer Maschine verlangt, nicht nur Fragen zu beantworten, sondern selbst kreative Lösungen zu finden, wie z.B. das Schreiben einer fantasievollen Geschichte nach gewissen Vorgaben (Bringsjord, 2003).

Ich möchte hier noch einen Schritt weitergehen. Mein Vorschlag zur Erweiterung des Turing-Tests ist die Einführung von Szenario-Fragen und die Herausforderung der Produktion von probabilistischen und plausiblen Zukunftsbildern. Damit wird dem ursprünglichen Anspruchsdenken des Menschen an seine Maschinen entsprochen, entscheidungsrelevante Informationen über alternative Zukünfte zu erhalten. In diesem Test-Setting, in dem wie im ursprünglichen Turing-Test ein menschlicher Beobachter mit einem Menschen und einer Maschine kommuniziert, würden im ersten Schritt die beiden Gesprächspartner:innen Daten erhalten. Mit diesen Daten muss ein auf statistischen Wahrscheinlichkeiten beruhendes einfaches Szenario (z.B. zu einer technischen oder wirtschaftlichen Fragestellung) kreiert werden.

Im zweiten Schritt interveniert die Beobachterin/der Beobachter und stellt eine „was-wäre-wenn“-Frage, deren Beantwortung sich nicht aus dem ursprünglichen Datensatz ableiten lässt, wie z.B. „Was wäre, wenn morgen eine globale Pandemie ausbräche, die Millionen Todesopfer fordert“ oder „Was wäre, wenn ich heute glücklich wäre“, oder „Was wäre, wenn es kein Geld mehr auf der Welt gäbe“, je nach Kontext. Diese Intervention verlangt die kreative Anpassung des Szenarios. Eine Maschine, die diesen Sprung der Kreativität mindestens genauso gut schafft wie ein Mensch, ist intelligent, weil sie mit „what-if“ umgehen, eigenständig Alternativen entwickeln kann und damit nicht nur bloß mächtige digitale Rechenleistung erbringen und simple Fragen beantworten, sondern Probleme erster und zweiter Ordnung lösen kann, vor allem also prinzipiell Fragen, die nicht ultimativ zu beantworten sind. Wenn Beobachter:innen nun feststellen, dass beide, Mensch und Maschine, in der Lage sind, ein vollständiges neues Szenario vorzulegen, das nicht nur statistisch wahrscheinlich ist, sondern auch plausibel, dann haben wir es tatsächlich mit einer intelligenten Maschine zu tun. In einem gegenwärtigen Forschungsprojekt beschäftige ich mich mit dem Design dieses Turing-Szenario-Tests. Dieser Test würde sich vor allem für die Anwendungen in der Technologie und in den Wirtschaftswissenschaften eignen, um z.B. die Zukunftsannahmen von Unternehmen in einem volatilen Umfeld durch intelligente Maschinen zu unterstützen. Das wäre der Weg zu maschinengestützten Zukunftsszenarien. Damit hätten wir – so es sie gibt – erstmals jene „superintelligenten“ Maschinen, die für uns einen wesentlichen Nutzen stiften können.

Wie entscheiden unsere Maschinen?

Wenn wir also unterstellen, dass es intelligente Maschinen geben könnte, und der alte Menschheitstraum wahr würde, ergeben sich sofort praktische Anwendungsprobleme. In den Wirtschaftswissenschaften können wir dabei ein faszinierendes Paraxodon beobachten. Obwohl die mathematischen Modelle in der Ökonomie in sich vollständig und richtig sind, und eine gewisse Eleganz haben, sieht die empirische Realität oft völlig anders aus, wie wir in der Finanzmarktkrise 2008 feststellen mussten. Auch globale Krisen, wie die Covid-19 Pandemie, konnten mit den klassischen Modellen nicht antizipiert werden.

Die Ursache dafür wurde längst festgestellt. Alle diese Modelle setzen stets rational handelnde Akteure voraus, den „homo oeconomicus“, den es in der Praxis nicht gibt. Ganz im Gegenteil, Menschen neigen dazu, unter Unsicherheit irrational zu handeln und verhalten sich oft ganz anders, als in den Modellprämissen unterstellt wird (Kahneman & Tversky, 1974). Wir haben es also tatsächlich mit einem „homo irrationalis“ oder „homo emotionalis“ zu tun. Manchmal entscheiden Menschen rational, manchmal nicht. Diese Erkenntnis hat sich in der Wissenschaft längst durchgesetzt, wie auch die Verleihung der Alfred Nobel-Gedächtnispreise in Wirtschaftswissenschaften an Kahneman, Shiller oder Thaler demonstriert. Während wir also viel über das Verhalten von Menschen unter Unsicherheit gelernt haben und unsere Modellwelten in der Wirtschaft entsprechend kritisch beleuchten müssen, wissen wir noch sehr wenig darüber, wie sich Maschinen unter Unsicherheit verhalten bzw. welches Verhalten wir als Menschen tatsächlich bevorzugen würden. Wie soll eine von uns konstruierte und eingesetzte, selbstlernende intelligente Maschine entscheiden, z.B. ein Roboter, oder eine Software mit künstlicher Intelligenz? Werden Maschinensysteme mit künstlicher Intelligenz zur einer „machina oeconomica“ führen, die dem ursprünglichen Gedanken des „homo oeconomicus“ entspricht und uns wieder auf das modellhafte Denken der klassischen Theorien zurückwirft, mit all seinem Vor- und Nachteilen? Oder werden wir eine „machina humana“ haben, die dem realistischen Menschenbild mit seinem irrationalen Verhalten entspricht, mit all seinen Vor- und Nachteilen? Oder gibt es einen dritten Weg, der beides nutzenstiftend miteinander verbindet?

Erste Forschungsergebnisse liefern dazu überraschende Einsichten.Computer-Bots verhalten sich überraschenderweise menschlicher, als man glaubt, und tragen langjährige „Konflikte“ miteinander aus (Tsvetkova et al., 2017). Künstliche Intelligenz und die ihr zugrundeliegenden Maschinen- und Lernsysteme sind oft ein Spiegelbild der sie erfindenden Menschen, und enthalten dieselben Vorurteile und irrationalen Verhaltensweisen wie diese. Andererseits wäre eine rein rationale Entscheidungsfindung in vielen Fällen (zumindest menschen-) weltfremd. Das sind ganz grundsätzliche Fragen, denen wir uns stellen müssen. Sie betreffen nicht nur die Definition, wann eine Maschine als intelligent gilt, sondern wie diese Intelligenz ausgestaltet sein soll, in welcher Form sie für Menschen nützlich sein kann, ob es Grenzen zu ihrer Weiterentwicklung geben sollte, und wer schließlich die Letztkontrolle über eine Entscheidung haben müsste - immer noch der Mensch selbst oder eine völlig unabhängige intelligente Maschine? Die Frage, ob wir eine „machina oeconomica“ haben wollen, also ein system-centric outcome, oder eine „machina humana“, also ein human-centric outcome, ist fundamental.

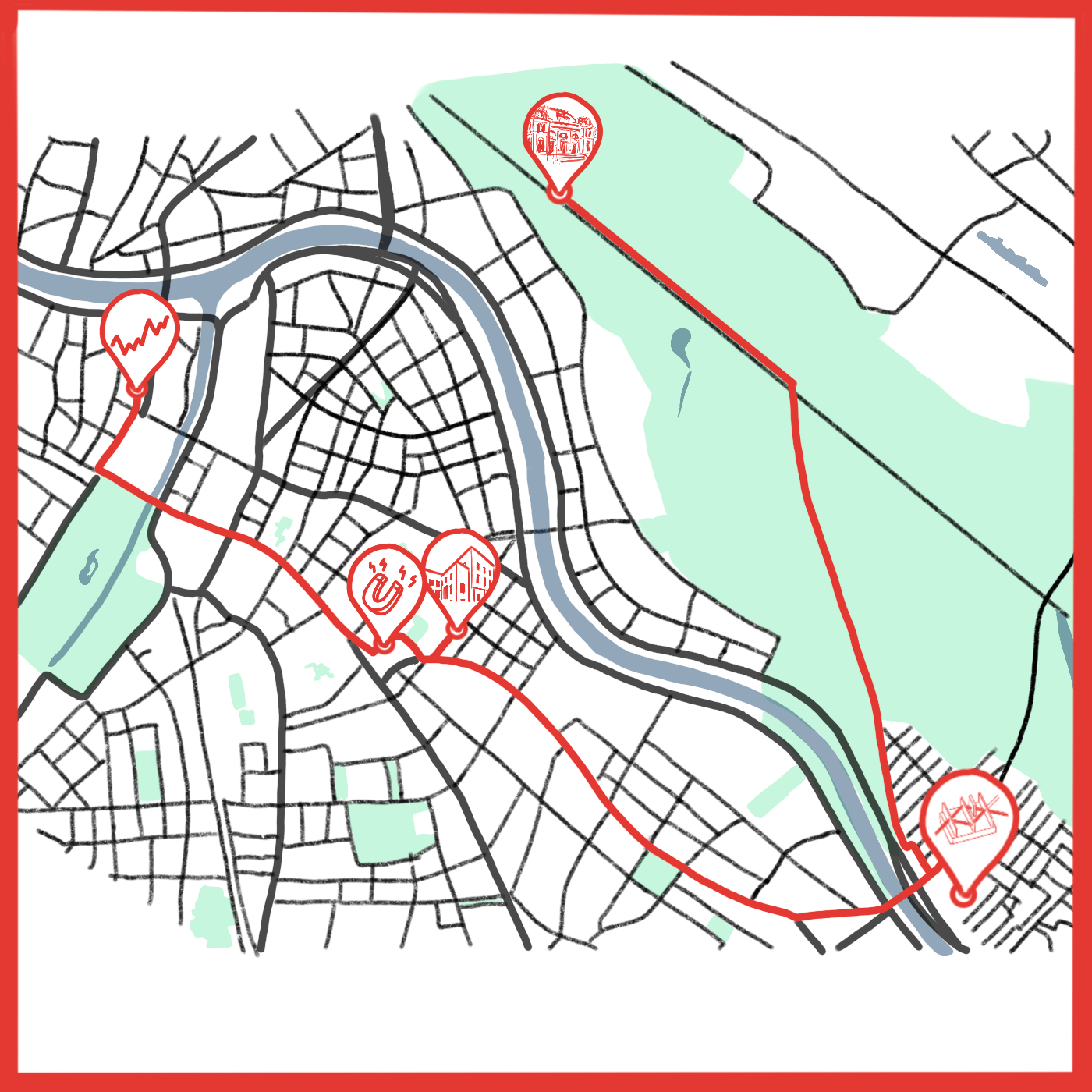

Abbildung 2: Gibt es neben machina oeconomica und machina humana noch einen dritten Weg?

Der ethische Imperativ als Lösungsansatz

Eine Möglichkeit, diesen gordischen Knoten zu lösen, ist der ethische Imperativ. Der sogenannte ethische bzw. kybernetische Imperativ wurde vom österreichischen Kybernetiker von Foerster postuliert: „Handle stets so, dass die Anzahl der Wahlmöglichkeiten größer wird.“ (Foerster, 2002, S. 303). Die Kollaboration von Menschen mit natürlicher Intelligenz und Maschinen mit künstlicher Intelligenz sollte demnach so gestaltet sein, dass es nie zu Ergebnissen kommt, welche die Optionen entsprechend dem menschlichen Wertekanon einschränken oder zu Entscheidungen führen, die nicht alle berechtigten Interessen berücksichtigen. Die Abwägung zwischen „machina oeconomica“ und „machina humana“ sollte sich daran orientieren, ein vielfältiges und nutzenstiftendes Ergebnis zu erzeugen.

Selbst wenn in dieser Kollaboration die Maschine einmal über überlegene Intelligenz verfügt, also eine, die auch kreativ sein und z.B. „was-wäre-wenn“-Fragen stellen und beantworten kann, könnte hier in der Beziehung des Menschen zu seinen Maschinen die Grenze gezogen werden. Das bedeutet, dass Maschinen, die diesem Anspruch nicht genügen, nicht eingesetzt werden sollten. Der ethische Imperativ ermöglicht eine Form von Intelligenz, die spontan fluktuieren kann. Das bedeutet, dass hier nicht bloß im Vorhinein festgelegte Algorithmen abgearbeitet werden.

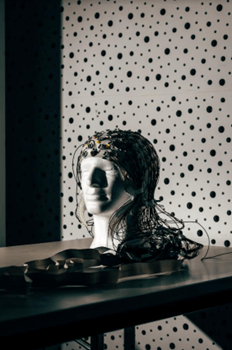

Es handelt sich dabei nicht nur um eine technologische oder wirtschaftswissenschaftliche Frage, sondern um eine philosophische. Obwohl die Geschichte über den Menschen und seine Maschinen bereits sehr alt ist, stehen wir im Bereich der künstlichen Intelligenz erst am Anfang. Die kommenden Jahre werden zeigen, ob wir mit kreativen und intelligenten Maschinen kooperieren können, und welche neuen Fragen und Muster sich daraus ergeben werden. Schließlich gibt es auch das Szenario der lebenden intelligenten Maschinen, in dem Biologie und Technologie ineinander zu einem lebenden Organismus verschmelzen, wie z.B. viren-getriebene Batterien, protein-basierte Wasserfilter oder gedankenlesende bionische Organe (Hockfield, 2019). Aber das ist eine ganz andere und sehr spannende Herausforderung, und darüber soll ein andermal berichtet werden.

Michael König studierte in Wien, London und Oxford und wurde 2012 an der Universität Wien in Wirtschaftswissenschaften promoviert. Er lehrt und forscht an der Wirtschaftsuniversität Wien am Department für Strategie und Innovation und ist Gastdozent an weiteren Hochschulen. Er ist mehrfacher Lehrpreisträger. In seiner Forschung beschäftigt er sich mit Strategic Foresight, mit Zukunftsszenarien, und mit der Frage, ob und ab wann man bei künstlicher Intelligenz tatsäch-lich von Intelligenz sprechen kann. Besonders interessiert ihn aus wirtschaftswissenschaftlicher Sicht, ob Maschinensysteme die „was wäre wenn“-Frage lösen können, wodurch maschinenunterstützte Szenarien für Unternehmen möglich werden.

Mayor, A. (2018). Gods and Robots: Myths, Machines, and Ancient Dreams of Technology. Princeton University Press.

Foerster, H.v. (1993). Wissen und Gewissen: Versuch einer Brücke. Suhrkamp.

Berry, M.J., Brivanlou, I.H., Jordan, T.A., & Meister, M. (1999). Anticipation of moving stimuli by the retina. Nature, 398, 334-338.

Legg, S., & Hutter, M. (2007). Universal Intelligence: A Definition of Machine Intelligence. Minds & Machines, 391-444.

Davis, M. (2018). The Universal Computer. The Road from Leibniz to Turing. Taylor & Francis.

Wiener, N. (1948). Cybernetics or the Control and Communication in the Animal and the Machine. Wiley.

Turing, A. (1950). Computing Machinery and Intelligence. Mind, LIX (236), 439-459.

Kahneman, D., & Tversky, A. (1974). Judgement under Uncertainty: Heuristics and Biases. Science, 185, 1124-1131.

Tsvetkova, M., Garcia-Gavilanes, R., Floridi, L., & Yasseri, T. (2017). Even good bots fight: The case of wikipedia. PLOS ONE, 1-13.

Pearl, J. (2018). The Limitations of Opaque Learning Machines. In Brockmann, J. (Hrsg). Possible Minds: 25 Ways of Looking at AI. Penguin Press.

Bringsjord, P.B., & Ferrucci, D. (2003). Creativity, the Turing-Test, and the (Better) Lovelace-Test. Studies in Cognitive Systems, 215-239.

Foerster, H.v. (2002). Understanding Understanding. Springer.

Hockfield, S. (2019). The Age of Living Machines. How Biology Will Build the Next Technology Revolution. Norton & Company.

.jpg)