Warum das wichtig ist: Heute werden viele Experimente in den Naturwissenschaften nicht mehr von Menschen, sondern von Maschinen durchgeführt. Je mehr Daten durch Experimente gewonnen werden, desto schwieriger wird es, sie verständlich zu interpretieren. Bioinformatiker:innen und Biomathematiker:innen haben diese Herausforderung angenommen und liefern so einen der wesentlichsten Beiträge für die Zukunft der Naturwissenschaft. Sie arbeiten daran, Ergebnisse auch mit großen Datenmengen in Modellen darstellen und richtig interpretieren zu können.

Anfang der 2000er gab es einen Punkt, an dem die Molekularbiologie von einer qualitativen zu einer quantitativen Disziplin wurde (Westerhoff & Palsson, 2004). Zählbare, also quantitative Daten wurden wichtiger – auch, um qualitative Aussagen machen zu können. Die bis dahin eher kleinen, interdisziplinären Gebiete der Biomathematik und -informatik wuchsen schnell und sind heutzutage in der naturwissenschaftlichen Forschung nicht mehr wegzudenken (Abdurakhmonov, 2016). Sie beschäftigen sich mit dem Informationsgewinn aus und der Darstellung von Daten, die bei Experimenten im Labor gewonnen werden. Beispielsweise wird die biotechnologische Entwicklung von Mikroorganismusstämmen, die gewünschte organische Moleküle produzieren, kaum noch ohne Stoffwechselmodelle, also mathematischen Darstellungen der biochemischen Reaktionen in einer Zelle, betrieben (Covert et al., 2001). Wie so häufig in der Biologie ist es auch hier einfach, große Mengen an Daten zu produzieren, und weniger einfach, aus ihnen Information zu gewinnen. Es ist mittlerweile schwer, eine molekularbiologische Publikation ohne statistische Auswertungen zu finden. Dies ist mehr eine Bedingung als eine Option geworden (Formatting Guide Nature, 2020). Deshalb sind die Bioinformatik, Biomathematik und auch die Statistik wesentliche Bestandteile der Forschung in den Naturwissenschaften geworden.

Alle Modelle sind falsch, aber manche sind nützlich

Der Zugang von Forscher:innen im Bereich der Naturwissenschaften beruht vor allem auf drei Fachgebieten: der mathematischen Darstellung von Stoffwechselvorgängen in Modellen, Laborautomatisierung und maschinellem Lernen. Während Biomathematik schon lange als etabliert gilt und sich stetig weiterentwickelt, sind die anderen beiden Bereiche neuartiger und werden wohl in den nächsten Jahren nicht mehr wegzudenken sein.

Das Modellieren von Stoffwechselvorgängen wird häufig als Ausgangspunkt für die Auswahl von Reaktionen verwendet, die beeinflusst werden können, um die biochemischen Vorgänge in einem System, zum Beispiel einer Zelle, in eine bestimmte Richtung zu lenken (Covert et al., 2001). Diese Modelle werden meistens als Netzwerke dargestellt, die man sich wie einen Rohrleitungsplan vorstellen kann. Da wir heutzutage diese Netzwerke leider noch nicht ganz so gut wie Rohrleitungen verstehen, wurden mehrere Darstellungszugänge entwickelt: Einschränkungsbasierte Modellierung (Constraint based Modeling) (Bordbar et al., 2014), Metabolische Flussanalyse (Metabolic Flux Analysis) (Antoniewicz, 2015) und Kinetische Modelle (Costa et al., 2016). Während jede dieser Variationen ihre eigenen Anwendungsgebiete hat, ist die Beschreibung der Verteilung der Stoffflüsse durch das biochemische Netzwerk ein übergreifendes Ziel.

Von all diesen Zugängen sind kinetische Modelle am schwierigsten zu konstruieren, sie liefern aber die relevantesten Ergebnisse. Um eines dieser Modelle zu konstruieren, müssen Unmengen an Informationen, also Daten, über die involvierten Reaktionen und Enzyme, ihre Abläufe, Reaktions- und Regulationsmechanismen und thermodynamischen Limits gesammelt und in die Modelle integriert werden (Saa & Nielsen, 2017).

Der dadurch beschriebene Stoffwechselweg entspricht natürlich nur unserem Bild der Vorgänge in Zellen, welches stark durch unser Wissen limitiert ist, und nicht der Natur selbst. Um einen berühmten Aphorismus, der dem Statistiker George Box zugeschrieben wird, zu zitieren: „Alle Modelle sind falsch, aber manche sind nützlich“ (Box, 1976).

Um bei der Rohrplan-Analogie zu bleiben: Es wird versucht zu beschreiben, wie schnell etwas durch bestimmte Leitungen fließt. Dabei ist nicht jeder beliebige Fluss möglich, die Rohrlänge und -breite, ein Ventil oder andere Regulationsmechanismen schränken den Bereich der möglichen Verteilungen ein. Diese dadurch limitierten Möglichkeiten erlauben nur eingeschränkte Lösungen für vorhergesagte Flüsse, sollten wir Teile dieses Netzwerkes modifizieren (Reed, 2012).

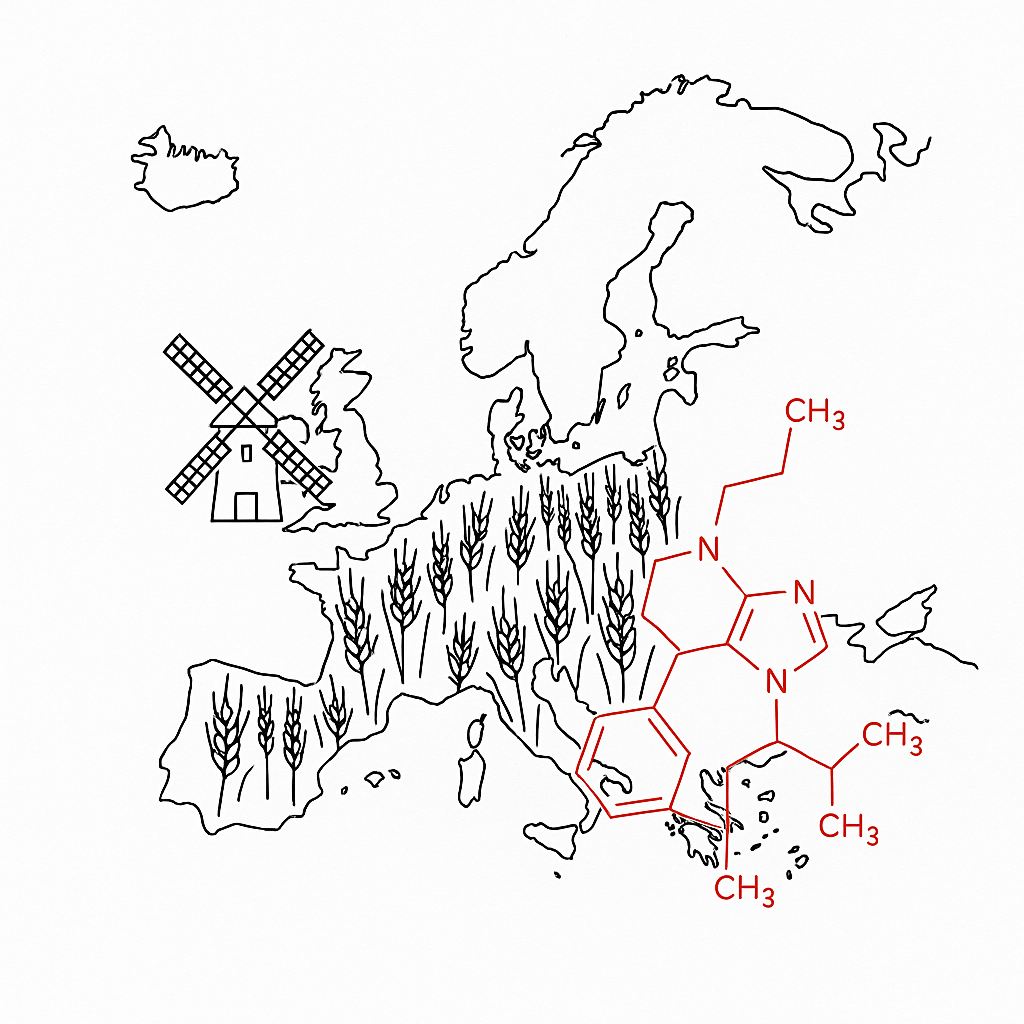

Abbildung 1: Stoffwechselweg von Glukose (Einfachzucker) in einem Organismus zur Gewinnung von Energie und Metaboliten

Wer die Daten gewinnt …

Das Ziel jeder Automatisierung ist Prozesse nicht nur einfacher und billiger zu machen, sondern vor allem den größten Störfaktor auszuschalten: den Menschen. Um mehr Informationen über verschiedene Systeme zu gewinnen, kommt es zur Modellierung von Daten. Dieser automatisierte Vorgang hilft dabei, Experimente reproduzierbarer und Ergebnisse robuster zu machen. Zusätzlich gibt es Laborautomatisierung, also jedes Laborequipment, das dem Menschen Arbeit abnimmt (Olsen, 2012). Während Thermocycler, die Wasserbäder mit verschiedenen Temperaturen abgelöst haben, oder Autosampler, die Proben nacheinander in Analysegeräte wie Massenspektrometer einschleusen, mittlerweile niemanden mehr beeindrucken, ist die Verwendung von Pipettier- oder Kultivierrobotern noch etwas Besonderes.

Experimentelle Wissenschaften haben ein großes Reproduzierbarkeitsproblem (Baker, 2016). Laborarbeit ist wie Kochen. Genauso wie die Gerichte verschiedener Köche, die in verschiedenen Küchen mit unterschiedlichen Utensilien arbeiten, unterschiedlich schmecken, können Datensätze von verschiedenen Laboren stark voneinander abweichen. Selbst wenn sie dasselbe Rezept befolgen. Es kommt darauf an, wer wann und wo einen Versuch durchführt. Diese Variationen erschweren es, die Datensätze richtig zu analysieren. (Brown et al., 2018). Definierte Schritte in kontrollierten Umgebungen, so genau wie sie nur von Maschinen ausgeführt werden können, helfen uns, dieses Problem zu minimieren (Check-Hayden, 2014). Prozesse in den Omics-Studien, wie die Sequenzierung eines ganzen Genoms, wurden durch die Entwicklung von Geräten wie automatischen Sequenzierern erst ermöglicht (Mavromatis et al., 2012). Die Aufgabe der Omics-Disziplinen (Eisen, 2012) ist es, alle Bestandteile einer biologischen Ebene aufzuzeichnen (Vailati-Riboni et al., 2017). Ohne weitreichende Datenanalyse wären diese aber sehr informationsarm.

Eines muss man Menschen im Vergleich mit Laborrobotern jedoch lassen: Wenn es um ein einziges Experiment geht sind sie etwa gleich schnell, oder langsam, wie Roboter. Durch Automatisierung werden einzelne Versuche meistens nicht beschleunigt, sondern eskaliert. Roboter können gleichzeitig hunderte oder sogar tausende Zelllinien kultivieren, modifizieren oder testen, während ein Mensch in derselben Zeit mit ein paar wenigen limitiert ist.

… und wer die Daten interpretiert

Es ist einfach, große Mengen an Daten zu produzieren, und weniger einfach, aus ihnen Information zu gewinnen. Neben den oben beschriebenen Modellierungsmethoden kommen hier auch klassisch statistische explorative Datenanalysen zum Einsatz, bei denen hauptsächlich Kreativität, Durchhaltevermögen und biologische Intuition gefragt sind. Maschinelles Lernen hingegen kann nicht-offensichtliche Strukturen in Daten finden, wodurch Zusammenhänge, die für Menschen nicht erkennbar sind, entdeckt werden können (Kim et al., 2019). Bei der Analyse von Strukturen und Mustern in Daten helfen heute Deep Learning und Neuronale Netzwerke. Verglichen mit maschinellem Lernen bringen diese Hilfsmittel ein weiteres Level an Abstraktion mit sich (LeCun et al., 2015). Genau dafür werden diese Methoden, vor allem in der wissenschaftlichen Anwendung, auch gerne kritisiert (Webb, 2018). Die Modelle überschreiten die menschliche Vorstellungskraft, wir können nicht mehr verstehen, worauf ihre Entscheidungen basieren (Zhang et al., 2016). Aber werden diese Modelle nicht genau dadurch noch interessanter? Nur weil wir sie (noch) nicht verstehen können heißt das nicht, dass wir sie nicht verwenden sollten. Denn mit der Zeit werden wir auch diese komplexen Modelle immer besser verstehen lernen. (Montavon et al., 2018; Samek et al., 2017; Yang et al., 2019).

Abbildung 2: Vom biologischen Prozess zu den Daten - wie ein Experiment abläuft: Zuerst passiert etwas, in unserem Fall ein biologischer Stoffwechselprozess in einer Zelle. Im zweiten Schritt beobachten Wissenschaftler:innen diesen Prozess mit verschiedenen technischen Hilfsmitteln und sammeln Daten. Dann werden diese Daten in Computer eingespeist und Modelle daraus konstruiert - und hier kommt die Bioinformatik ins Spiel.

Wofür wir Roboter brauchen

Da die Genauigkeit und Reproduzierbarkeit von Daten, wie sie für die Bioinformatik notwendig sind, stark vom Menschen abhängen, steht der Forschung mit der Automatisierung von Laborarbeit ein Umschwung bevor (Check Hayden, 2014). Roboter können genauer, schneller und billiger arbeiten als wir Menschen (Bailey et al., 2019). Das wird in ein paar Jahren die Frage aufwerfen: Warum machen wir unsere Experimente noch selbst?

In meinem PhD-Projekt soll ein objektiver Arbeitsablauf geschaffen werden, also mit so wenig menschlichem Einfluss wie möglich, der Bakterienstämme mit gewünschten Eigenschaften, wie beispielsweise einem höheren Ertrag an Insulin für den medizinischen Einsatz, produzieren kann. Dafür verwenden wir ein Wechselspiel von automatisierter Laborarbeit, kinetischen Stoffwechselmodellen und maschinellem Lernen. Die Laborroboter züchten unsere Stämme, bearbeiten einzelne Gene und messen dann den Einfluss dieser Veränderungen auf die Metaboliten, Proteine, etc. in unseren mikrobiellen Arbeitskollegen, zum Beispiel den Bakterien (Gallagher et al. , 2014; Prabhu & Urban, 2017). In einem Durchlauf werden dadurch nicht nur ein paar wenige, sondern tausende bis zehntausende Stämme von Mikroorganismen gleichzeitig behandelt (Bassalo et al., 2018; Si et al., 2017).

Mit dieser Information lassen sich Stoffwechselmodelle verfeinern (Fondi & Liò, 2015) oder, in ein paar Jahren, sogar von Grund auf konstruieren. Zusammen mit maschinellem Lernen und diesen Modellen lässt sich dann ermitteln, welche Modifikationen wir nach bestem Ermessen in der nächsten Runde dieses Kreislaufes kombinieren möchten (Borkowski et al., 2019); ein „educated guess“ mit möglichst viel Information als Basis.

Conclusio: Warum machen wir Experimente noch selbst?

Wir gehen stark davon aus, dass Computer und Automatisierung in sehr naher Zukunft eine noch größere Rolle im Forschungsalltag spielen werden (Bailey et al., 2019). Vor allem Laborarbeit wird bald von Robotern übernommen werden, die diese Arbeit schneller, genauer, reproduzierbarer und billiger machen können. Deswegen brauchen wir mehr denn je standardisierte Methoden (Hollmann et al., 2018), dazu Forscher, die diese Roboter trainieren und programmieren können, und eine nachvollziehbare Datenverarbeitung. („Is there a place for biologists in the age of automation?“, 2019) Dieser Wandel zu mehr Automatisierung bringt allerdings auch einige Probleme mit sich. Nicht jede Arbeitsgruppe kann sich Roboter und das neueste Equipment leisten, wodurch Druck entsteht, sich auf spezialisierte Studien zu konzentrieren, die weniger Versuche und somit weniger quantitative Daten für relevante Ergebnisse benötigen (low-throughput Studien). (Jones et al., 2019). Meistens ist es für Arbeitsgruppen, die große Studien durchführen, leichter, einflussreiche Publikationen zu schreiben. Genau diese sind jedoch einer der ausschlaggebenden Faktoren bei der Zuschreibung von Förderungen. Dadurch wird es immer leichter für etablierte Gruppen, mehr und mehr Unterstützungen zu erhalten, während kleinere Gruppen fast ausnahmslos unterfinanziert sind (“Research funding: the problem with priorities,” 2003). Forschungsförderung wird also auch in Zukunft nur noch essentieller und überlebenswichtiger für gute Wissenschaft werden (Belluz et al., 2016).

Bioinformatik arbeitet daran, neue und bessere Interpretations- und Auswertungsmöglichkeiten für Daten zu entwickeln. Das Experiment, aus dem die Daten gewonnen werden, ist nur der erste Schritt – erst danach kommt der Punkt, an dem wir etwas Neues über die Welt oder, in unserem Fall, den menschlichen Stoffwechsel lernen können. Die überwältigende Menge an Daten, die wir heute dank modernem technischem Instrumentarium gewinnen können, muss mithilfe von Modellen und künstlichen Intelligenzen erst verständlich gemacht werden. Die Disziplin der Bioinformatik hilft dabei, etwas mehr mathematische Ordnung in das Chaos der Daten zu bringen. Einige Experimente machen schon heute Roboter für uns, und in Zukunft werden sie den Menschen als Experimentator:in vielleicht vollständig ersetzt haben. Doch die Aufgabe, die uns wirklich neue Erkenntnisse bringt, wird letztlich noch immer vom Menschen selbst durchgeführt. Schlussendlich sind Computer nur so schlau wie die Programme, die auf ihnen laufen. Wir brauchen immer noch Leute, die diese Programme schreiben und wissen, wo und wie man sie richtig einsetzt.

Matthias Mattanovich studierte Biotechnologie an der Universität für Bodenkultur in Wien (BOKU) und beschäftigte sich dort theoretisch mit Bioinformatik. Um sein Wissen zu vertiefen ging er für seine Doktorarbeit an die Dänische Technische Universität (DTU), um im Novo Nordisk Foundation Center for Biosustainability zu arbeiten. Momentan ist er in der Planungsphase seines PhD-Projekts, das ihm die Möglichkeit bietet, neue wissenschaftliche Methoden zu erlernen, was für ihn einen ebenso hohen Stellenwert hat wie die Endergebnisse selbst.

- Eine kurze Video-Einführung in die Bioinformatik: Was ist Bioinformatik? (3sat)

- Ein Paper zur Bioinformatik und ihren Einfluss auf die Medizin (englisch): Bioinformatics (NCBI)

- Wie hat sich die Bioinformatik entwickelt - und was ist von ihr zu erwarten? Bioinformatik weckt Erwartungen (NZZ)

- Ein Bioinformatiker im Gespräch über sein Arbeitsfeld: Computer lernt wie unser Gehirn (Die Presse)

- Abdurakhmonov, I. Y. (2016). Bioinformatics: basics, development, and future. In I. Y. Abdurakhmonov (Ed.), Bioinformatics - Updated Features and Applications. InTech. https://doi.org/10.5772/63817

- Antoniewicz, M. R. (2015). Methods and advances in metabolic flux analysis: a mini-review. Journal of Industrial Microbiology & Biotechnology, 42(3), 317–325. https://doi.org/10.1007/s10295-015-1585-x

- Bailey, A. L., Ledeboer, N., & Burnham, C.-A. D. (2019). Clinical microbiology is growing up: the total laboratory automation revolution. Clinical Chemistry, 65(5), 634–643. https://doi.org/10.1373/clinchem.2017.274522

- Baker, M. (2016). 1,500 scientists lift the lid on reproducibility. Nature, 533(7604), 452–454. https://doi.org/10.1038/533452a

- Bassalo, M. C., Garst, A. D., Choudhury, A., Grau, W. C., Oh, E. J., Spindler, E., … Gill, R. T. (2018). Deep scanning lysine metabolism in Escherichia coli. Molecular Systems Biology, 14(11), e8371. https://doi.org/10.15252/msb.20188371

- Belluz, J., Plumer, B., & Resnick, B. (2016). The 7 biggest problems facing science, according to 270 scientists. Vox.

- Bordbar, A., Monk, J. M., King, Z. A., & Palsson, B. O. (2014). Constraint-based models predict metabolic and associated cellular functions. Nature Reviews. Genetics, 15(2), 107–120. https://doi.org/10.1038/nrg3643

- Borkowski, O., Koch, M., Zettor, A., Pandi, A., Cardoso Batista, A., Soudier, P., & Faulon, J.-L. (2019). Large scale active-learning-guided exploration to maximize cell-free production. BioRxiv. https://doi.org/10.1101/751669

- Box, G. E. P. (1976). Science and Statistics. Journal of the American Statistical Association, 71(356), 791–799. https://doi.org/10.1080/01621459.1976.10480949

- Brown, A. W., Kaiser, K. A., & Allison, D. B. (2018). Issues with data and analyses: Errors, underlying themes, and potential solutions. Proceedings of the National Academy of Sciences of the United States of America, 115(11), 2563–2570. https://doi.org/10.1073/pnas.1708279115

- Check Hayden, E. (2014). The automated lab. Nature, 516(7529), 131–132. https://doi.org/10.1038/516131a

- Costa, R. S., Hartmann, A., & Vinga, S. (2016). Kinetic modeling of cell metabolism for microbial production. Journal of Biotechnology, 219, 126–141. https://doi.org/10.1016/j.jbiotec.2015.12.023

- Covert, M. W., Schilling, C. H., Famili, I., Edwards, J. S., Goryanin, I. I., Selkov, E., & Palsson, B. O. (2001). Metabolic modeling of microbial strains in silico. Trends in Biochemical Sciences, 26(3), 179–186. https://doi.org/10.1016/s0968-0004(00)01754-0

- Eisen, J. A. (2012). Badomics words and the power and peril of the ome-meme. GigaScience, 1(1), 6. https://doi.org/10.1186/2047-217X-1-6

- Fondi, M., & Liò, P. (2015). Multi -omics and metabolic modelling pipelines: challenges and tools for systems microbiology. Microbiological Research, 171, 52–64. https://doi.org/10.1016/j.micres.2015.01.003

- Formatting guide | Nature. (n.d.). Retrieved March 22, 2020, from https://www.nature.com/nature/for-authors/formatting-guide

- Gallagher, R. R., Li, Z., Lewis, A. O., & Isaacs, F. J. (2014). Rapid editing and evolution of bacterial genomes using libraries of synthetic DNA. Nature Protocols, 9(10), 2301–2316. https://doi.org/10.1038/nprot.2014.082

- Hollmann, S., Regierer, B., D’Elia, D., Gruden, K., Baebler, Š., Frohme, M., … Kremer, A. (2018). Standardisation in life-science research - Making the case for harmonization to improve communication and sharing of data amongst researchers (EasyChair Preprints). EasyChair. https://doi.org/10.29007/4xkd

- Is there a place for biologists in the age of automation? - SynBioBeta. (n.d.). Retrieved March 23, 2020, from https://synbiobeta.com/is-there-a-place-for-biologists-in-the-age-of-automation/

- Jones, E., Glover, B., & Kalantery, N. (2019). Research 4.0: Interim Report.

- Kim, G. B., Kim, W. J., Kim, H. U., & Lee, S. Y. (2019). Machine learning applications in systems metabolic engineering. Current Opinion in Biotechnology, 64, 1–9. https://doi.org/10.1016/j.copbio.2019.08.010

- LeCun, Y., Bengio, Y., & Hinton, G. (2015). Deep learning. Nature, 521(7553), 436–444. https://doi.org/10.1038/nature14539

- Mavromatis, K., Land, M. L., Brettin, T. S., Quest, D. J., Copeland, A., Clum, A., … Kyrpides, N. C. (2012). The fast changing landscape of sequencing technologies and their impact on microbial genome assemblies and annotation. Plos One, 7(12), e48837. https://doi.org/10.1371/journal.pone.0048837

- Montavon, G., Samek, W., & Müller, K.-R. (2018). Methods for interpreting and understanding deep neural networks. Digital Signal Processing, 73, 1–15. https://doi.org/10.1016/j.dsp.2017.10.011

- Olsen, K. (2012). The first 110 years of laboratory automation: technologies, applications, and the creative scientist. Journal of Laboratory Automation, 17(6), 469–480. https://doi.org/10.1177/2211068212455631

- Prabhu, G. R. D., & Urban, P. L. (2017). The dawn of unmanned analytical laboratories. TrAC Trends in Analytical Chemistry, 88, 41–52. https://doi.org/10.1016/j.trac.2016.12.011

- Reed, J. L. (2012). Shrinking the metabolic solution space using experimental datasets. PLoS Computational Biology, 8(8), e1002662. https://doi.org/10.1371/journal.pcbi.1002662

- Research funding: the problem with priorities. (2003). Nature Materials, 2(10), 639–639. https://doi.org/10.1038/nmat992

- Saa, P. A., & Nielsen, L. K. (2017). Formulation, construction and analysis of kinetic models of metabolism: A review of modelling frameworks. Biotechnology Advances, 35(8), 981–1003. https://doi.org/10.1016/j.biotechadv.2017.09.005

- Samek, W., Wiegand, T., & Müller, K.-R. (2017). Explainable Artificial Intelligence: Understanding, Visualizing and Interpreting Deep Learning Models. ArXiv.

- Si, T., Chao, R., Min, Y., Wu, Y., Ren, W., & Zhao, H. (2017). Automated multiplex genome-scale engineering in yeast. Nature Communications, 8, 15187. https://doi.org/10.1038/ncomms15187

- Vailati-Riboni, M., Palombo, V., & Loor, J. J. (2017). What are omics sciences? In B. N. Ametaj (Ed.), Periparturient diseases of dairy cows (pp. 1–7). Cham: Springer International Publishing. https://doi.org/10.1007/978-3-319-43033-1_1

- Webb, S. (2018). Deep learning for biology. Nature, 554(7693), 555–557. https://doi.org/10.1038/d41586-018-02174-z

- Westerhoff, H. V., & Palsson, B. O. (2004). The evolution of molecular biology into systems biology. Nature Biotechnology, 22(10), 1249–1252. https://doi.org/10.1038/nbt1020

- Yang, J. H., Wright, S. N., Hamblin, M., McCloskey, D., Alcantar, M. A., Schrübbers, L., … Collins, J. J. (2019). A White-Box Machine Learning Approach for Revealing Antibiotic Mechanisms of Action. Cell, 177(6), 1649–1661.e9. https://doi.org/10.1016/j.cell.2019.04.016

- Zhang, C., Bengio, S., Hardt, M., Recht, B., & Vinyals, O. (2016). Understanding deep learning requires rethinking generalization. ArXiv.

.jpg)