Warum das wichtig ist: Selbst wenn wir möglichst fair und wertfrei zu entscheiden versuchen, spielen persönliche Präferenzen und Vorlieben noch immer eine Rolle darin, wie wir andere Menschen beurteilen und einschätzen. Dies wird auch bei Vorstellungsgesprächen und Einstellungspolitik sichtbar. Das Projekt DEBIAS untersucht, wie Vorstellungsgespräche - und damit der Arbeitsmarkt - fairer gestaltet werden kann. Es stützt sich dabei auf die drei Prinzipien Anonymisierung, Strukturierung und vergleichende Bewertungen.

Dieser Beitrag erscheint in der Reihe science&policy. In diesem Schwerpunkt setzt sich alexandria mit der Frage auseinander, wie Politik und Wissenschaft sich gegenseitig beeinflussen und wie die Wissenschaft bei gesellschaftspolitischen Entscheidungen helfen kann. Mehr dazu findest du hier.

Unconscious Bias und Recruiting: Von schönen Menschen und den Tücken unserer Kognition

Wer „schön“ ist, verdient mehr, findet leichter einen Job, und wird öfter als kompetent wahrgenommen: Diese gut belegten Effekte sind auf Eigenheiten der menschlichen Kognition zurückzuführen und werden meist unter dem Begriff ‚Unconscious Bias‘ – unterbewusste Verzerrung – zusammengefasst. Diese Verzerrung führt zu einer ganzen Reihe an gesellschaftlichen Missständen, allen voran zu Diskriminierung und Ungleichbehandlung am Arbeitsmarkt. Bereits in den frühen 90er Jahren konnten die Ökonomen Hamermesh und Biddle (1993) den Zusammenhang zwischen konventioneller physischer Attraktivität und durchschnittlichem Gehalt als sogenanntes „Beauty Premium“ nachweisen. Aber es geht nicht nur um das Aussehen – auch Gender, Alter, ethnische Herkunft oder Hautfarbe spielen eine Rolle. Oft handelt es sich nicht um absichtliche Benachteiligung – Unconscious Bias ist eben un(ter)bewusst und betrifft damit auch jene Menschen, die eigentlich so fair wie möglich zu entscheiden versuchen.

Dass diese Effekte gerade im Bereich des Recruiting, im Jobinterview oder Einstellungsgespräch höchst problematisch sind, ist längst bekannt. Wirft man einen Blick auf einschlägige Fachliteratur, wird schnell klar: Diversity ist im Firmenkontext in aller Munde, und trotzdem sorgt Unconscious Bias im Recruiting oft dafür, dass die neuen Kolleg:innen erst recht wieder genauso aussehen, heißen und mit derselben Biographie aufwarten können wie die bestehende Belegschaft (Noon, 2018). Auch die zunehmend üblichen Diversity- und Anti-Diskriminierungs-Workshops, die vor allem auf Bewusstseinsbildung bei den Mitarbeiter:innen abzielen, schaffen hier nur bedingt Abhilfe. Die Effekte dieser Trainings helfen nur kurzfristig und führen nur selten zu nachhaltigen Veränderungen in der Unternehmenskultur (Ashley, 2010).

Hoffnungsträgerin Künstliche Intelligenz?

In Zeiten der Digitalen Transformation der Gesellschaft werden bei jedweden gesellschaftlichen Problemen schnell die Rufe nach digitalen Tools laut, um den Problemen zu begegnen. Aktuell ist ‚AI‘ – Anwendungen, die auf künstlicher Intelligenz beruhen – in aller Munde, und verspricht für den Recruiting-Bereich Effizienz-Steigerungen und ‚objektive‘ Bewertungs- und Auswahlmechanismen frei vom menschlichen Bias. So sollen in Screening-Prozessen durch Big-Data-Analysen hunderte, ja tausende Bewerbungen und Lebensläufe automatisch vorselektiert und bewertet werden, und den menschlichen Entscheidungsträger:innen schlussendlich nur mehr die Besten der Besten vorgelegt werden.

Diesen Versprechungen stehen allerdings die Vielzahl an Beispielen von AI-Systemen gegenüber, die ganz und gar nicht fair oder frei von Bias sind. Allen voran steht hier das Beispiel des Recruiting-Tools von Amazon, das selbstständig lernte, Frauen aufgrund ihrer Biographie und ohne weitere Informationen über deren Gender-Identität auszuselektieren, nur weil diese etwa eine bestimmte Universität besuchten. Dieser Fall illustriert das Kernproblem datenbasierten Technologien: Weder sind Daten jemals wirklich ‚objektiv‘, noch stellen die Korrelationen, die diese Analyse-Tools erkennen, adäquate Prädiktoren für die spätere Performance einzelner Bewerber:innen im Job dar. Abgesehen von den inhärenten Problemen dieser Technologien in Bezug auf Bias und Diskriminierung haben diese Tools noch weitere problematische Eigenschaften: Weder sind Entscheidungen transparent nachvollziehbar, noch gibt es gute Lösungen, um von diesen Systemen Rechenschaft über die internen Prozesse zu verlangen: ‚Accountability‘ bleibt eines der ungelösten Probleme von AI und algorithmischen Systemen.

Prädiktoren sind Variablen, die eine Voraussage über zukünftiges Auftreten von Ereignissen erlauben sollen. Wenn etwa von 1.000 Personen all jene, die einen Kredit nicht zurückzahlen können, auch blaue Augen haben, erkennen algorithmische Systeme diese Korrelation. Der Algorithmus sagt dann für die nächste Person mit blauen Augen voraus, sie würde ihren Kredit auch nicht begleichen. Das absurde Beispiel illustriert jedoch die Problematik: Korrelationen, also Zusammenhänge, müssen noch nicht Kausalität, also Verursachung, bedeuten – denn es scheint unsinnig, zu denken, Menschen könnten ihre Kredite nicht zurückzahlen, weil sie blaue Augen haben. Der Grund, warum sie ihre Kredite nicht zurückzahlen können, bleibt damit ungeklärt.

Abbildung 1: Künstliche Intelligenz ist nur bedingt eine Antwort auf die Frage, wie wir Bewerbungsgespräche fairer gestalten können

What works?

Wie die Verhaltensökonomin Iris Bohnet in ihrem Buch ‚What Works: Gender Equality by Design‘ (Bohnet, 2016) beschreibt, braucht es vielleicht gar keine undurchsichtige Hochtechnologie, um den Problemen des menschlichen Bias zu begegnen. Management- und Arbeitswissenschaften sowie Psychologie und Kognitionswissenschaften beschäftigten sich bereits lange vor dem Aufkommen digitaler Technologien mit diesen Problemen, und liefern auch empirisch bestätigte Lösungsansätze.

Allen voran steht natürlich die Anonymisierung: Wer nicht weiß, wie die Bewerber:innen aussehen, welches Alter sie haben oder welchen Nachnamen sie führen, kann auch nicht von diesen Eindrücken beeinflusst werden. Auch wenn manche Unternehmen bereits (teil-)anonymisierte Bewerbungsprozesse einsetzen, ist diese Praxis in Österreich noch eher selten, zumal sie auch mit erhöhten Aufwänden verbunden ist. Immerhin müssen mindestens zwei Mitarbeiter:innen an jedem Bewerbungsprozess teilnehmen, um die Anonymisierung von Bewerbungsunterlagen vorzunehmen.

Das größte Hindernis ist in diesem Kontext jedoch sicherlich die Weigerung vieler Human-Resources-Expert:innen, auf das persönliche, unstrukturierte Interview zu verzichten. Wissenschaftlichen Ergebnissen zum Trotz zeigen Umfragen unter HR-Manager:innen regelmäßig, dass das unstrukturierte, informelle Interview als die effektivste Methode zur Einschätzung der zukünftigen Performance von potentiellen Mitarbeiter:innen gesehen wird. Strukturierte Interviews, Tests und andere Formen der analytischen Bewertung von Bewerber:innen sind jedoch empirisch nachgewiesen die überwiegend effizientere Methode, diese Einschätzungen zu treffen. Diese Diskrepanz – „the greatest failure of industrial and organized psychology” (Bohnet, 2016) – fußt wohl auf der systematischen Überschätzung der eigenen Expertise und Erfahrung von Interviewer:innen, und ist nur schwer zu überwinden.

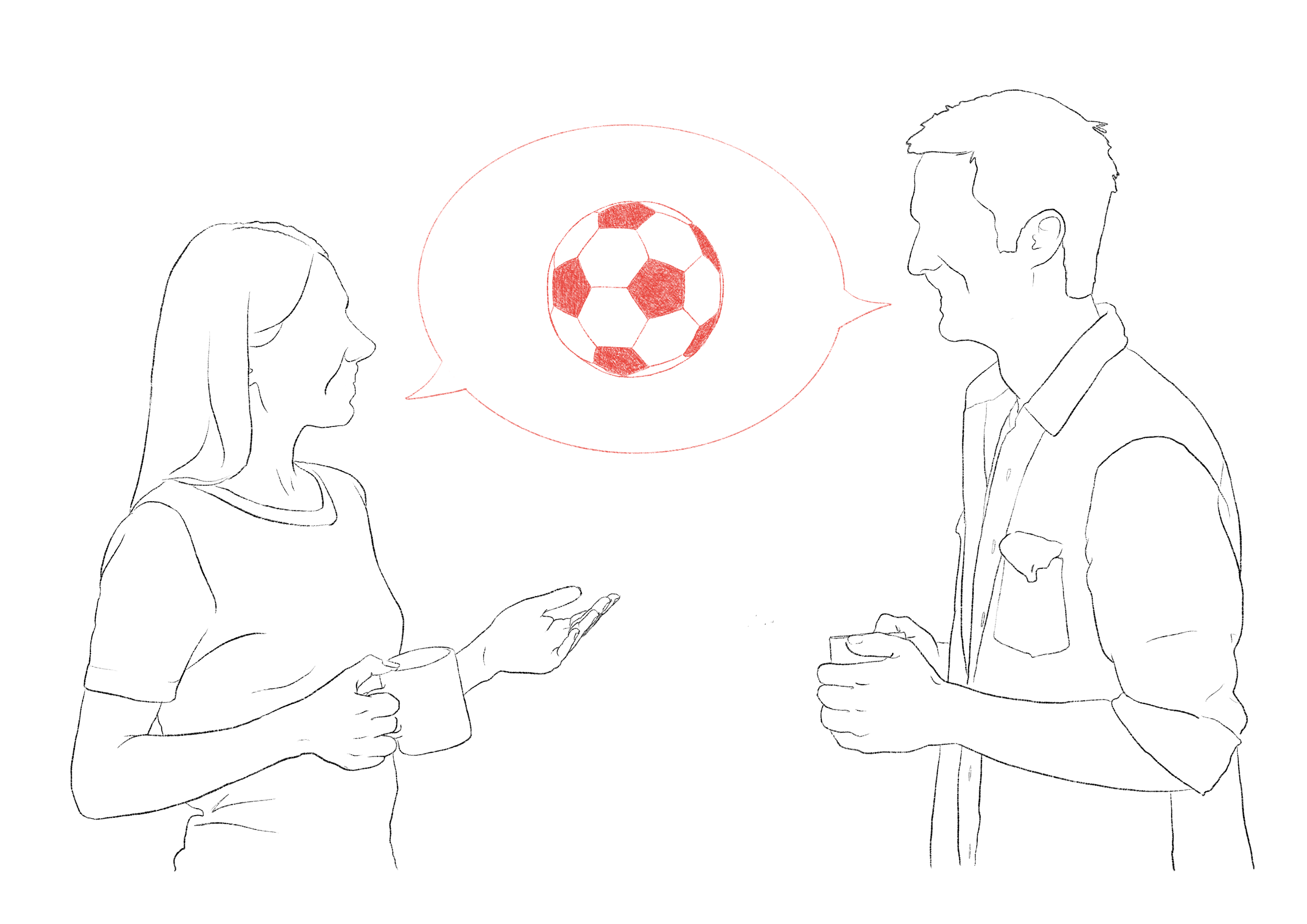

Bias kommen auch bei Bewertung der Bewerber:innen ins Spiel. Wie Bohnet ausführlich beschreibt, lassen sich eine Vielzahl an unbewussten, verzerrenden Effekten bei der Bewertung verhindern, indem diese strukturiert und vergleichend durchgeführt wird. Dies setzt natürlich voraus, dass die zuvor abgehaltenen Interviews vergleichbar sind. Ein fairer Vergleich zwischen der Person, die dreißig Minuten mit den Interviewer:innen über das gemeinsame Hobby Fußball geplaudert hat, und derjenigen, die dreißig Minuten hoch-technische Fragen zu IT-Kompetenzen beantwortet hat, ist schlicht nicht möglich. Trotzdem sorgt etwa der Affinity-Bias – wir sind gegenüber Personen, die uns ähnlicher sind, positiver eingestellt – in manchem Fall dann dafür, dass schlussendlich doch die fußballbegeisterte Person als geeigneter erscheinen mag.

Illustration 2: Auch wenn wir versuchen, möglichst fair zu entscheiden, stehen uns unbewusst persönliche Präferenzen im Weg.

DEBIAS: Eine sozio-technische Lösung mit dem Menschen im Mittelpunkt

Ausgehend von diesen drei Grundstrategien – Anonymisierung, Strukturierung und vergleichende Bewertung – entwickeln wir am Centre for Informatics and Society (C!S) an der TU Wien eine sozio-technische Lösung, um den Recruitingprozess fairer und weniger Bias-behaftet zu gestalten. In Kooperation mit dem TU Career Center und gefördert durch den Digitalisierungsfond der AK Wien schaffen wir mit dem DEBIAS Tool eine Möglichkeit, die oben beschriebenen Erkenntnisse in die Praxis umzusetzen, und konnten dieses im Rahmen der „Voice of Diversity“-Eventreihe an der TU Wien auch in realen Interview-Settings bereits evaluieren.

Das DEBIAS-Tool ist eine digitale Plattform, die es Bewerber:innen und Interviewer:innen ermöglicht, in einem zweistufigen, teil-anonymisierten Prozess Bewerbungsgespräche durchzuführen.

Am Anfang dieses Prozesses stehen speziell designte Workshops für Bewerber:innen und Unternehmensvertreter:innen, die sowohl das Tool selbst vorstellen als auch Hintergrundinformationen zu Unconscious Bias und der Relevanz von Diversity geben. Das Tool selbst teilt den Interviewprozess in einen anonymen Chat, welcher durch von den Unternehmen im Vorhinein definierte Fragen strukturiert wird, und ein persönliches, unstrukturiertes Gespräch, das erst nach dem Chat und dessen Bewertung geführt wird.

Die Struktur des Chats gibt somit vor, dass alle Bewerber:innen für ein und denselben Job dieselben Fragen in derselben Reihenfolge gestellt bekommen. Die Antworten auf und der Austausch zu diesen Fragen muss quantitativ bewertet werden, bevor zur nächsten Frage übergegangen werden kann. Auch das klassische, persönliche Gespräch im Anschluss wird bewertet, und im Zuge der Bewerber:innenauswahl durch die Unternehmen im Tool den anonymisierten Bewertungen gegenübergestellt. Eine Reihe an Analyse- und Visualisierungstools für den Bewertungsprozess runden das Tool ab.

Die Ergebnisse der Evaluation zeigen erste Erfolge: Zum einen ist der Kontrast zwischen dem anonymen Chat und dem persönlichen Gespräch bereits hilfreich, den eigenen Bias direkt zu reflektieren. Viele Interviewer:innen zeigten sich überrascht, wenn die eigenen Erwartungen nach dem Chat mehrheitlich enttäuscht werden. Zum anderen erlauben die Gegenüberstellung zwischen den Bewertungen des persönlichen Gesprächs und des strukturierten Chats Rückschlüsse auf die Frage, wie aussagekräftig die Performance in einem anonymen Austausch bewertet werden kann. Hier zeigt sich, dass Bewerber:innen im Allgemeinen genauso gut oder schlecht im Chat wie im Gespräch abschneiden, und sich persönliche Präferenzen für das eine oder andere Medium durch die Abfolge gut ausgleichen. Ein interessanter Nebeneffekt für die Bewerber:innen war auch, dass die Chats eine beruhigende, entschleunigende Wirkung hatten. Nachdem – im Gegensatz zu einem face-to-face Interview – beide Seiten etwas länger für die Antworten brauchten, berichteten Bewerber:innen von weniger Stress und „Lampenfieber“ beim textuellen Austausch.

Interdisziplinarität statt Techno-Determinismus

Das Problem des Unconscious Bias im Recruiting-Prozess zu lösen, bleibt natürlich weiterhin eine Herausforderung und wird sich nicht durch einzelne Interventionen wie das DEBIAS Tool aus der Welt schaffen lassen. Nichtsdestotrotz illustriert das Tool eine mögliche Herangehensweise an solch soziale Probleme aus einer interdisziplinären Perspektive, ohne einem blinden Techno-Determinismus zu verfallen und Menschen zu ersetzen, statt sie zu ermächtigen. Oftmals sind es dann prozedurale und praktische Umsetzung von Erkenntnissen aus den wissenschaftlichen Kerndisziplinen, die sich mit dem spezifischen Problem auseinandersetzen, die auf niederschwellige Art Erfolg versprechen. Im Fall von Unconscious Bias sind das relativ simple Maßnahmen. Diese können zusammen mit ausgereiften und empirisch erprobten Technologien dort unterstützend eingreifen, wo die Schwächen der menschlichen Kognition besonders offenbar werden. Ohne jedoch die Bereiche, in denen der Mensch der Maschine weiterhin klar überlegen ist, einzuschränken.

Florian Cech ist Forschungsassistent und Doktorand am Center for Technology and Society (CTS). Sein Forschungsfokus liegt auf Aspekten der Digitalen Transformation der Gesellschaft in Zusammenhang mit Algorithmic Accountability, Transparenz und User Interface Design, und er lehrt zu Critical Algorithm Studies an der Fakultät für Informatik der TU Wien.

Besuche hier die Website des Projekts.

Ashley, L. (2010). Making a difference? The use (and abuse) of diversity management at the UK’s elite law firms. Work Employ Soc, 24,

711–727. https://doi.org/10.1177/0950017010380639

Bohnet, I. (2016). What Works. Harvard University Press.

Hamermesh, D., & Biddle, J. (1993). Beauty and the Labor Market, 1–183. https://doi.org/10.3386/w4518

Noon, M. (2018). Pointless Diversity Training: Unconscious Bias, New Racism and Agency. Work Employ Soc, 32, 198–209.

https://doi.org/10.1177/0950017017719841

Dieser Beitrag entstand in Kooperation mit der AK Wien. Er wurde von alexandria in redaktioneller Unabhängigkeit realisiert. Mehr Infos zur Kooperation gibt es hier.

.jpg)